Erfüllt die CSAM-Erkennung von Apple wirklich ihren ursprünglichen Zweck?

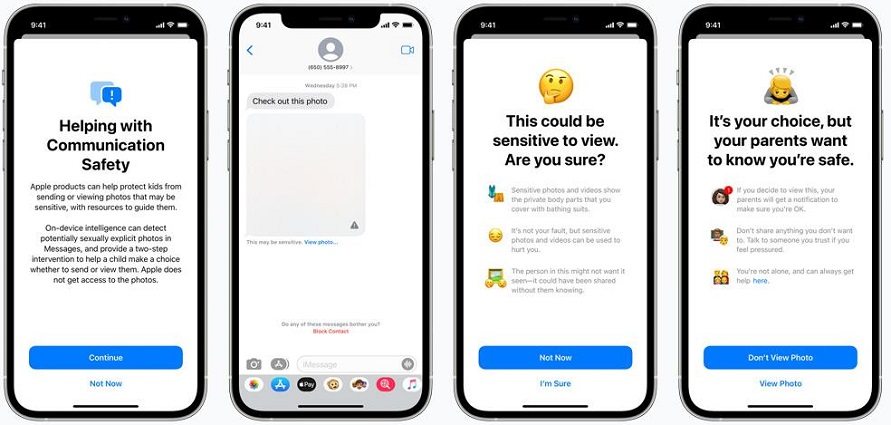

Apple hat eine Reihe neuer technologischer Maßnahmen eingeführt, um Kindesmissbrauch zu verhindern. Das maschinelle Lernen wird in der Opt-in-Einstellung in den iCloud-Familienkonten verwendet, um Nacktheit auf den Bildern zu erkennen. Das System blockiert den Empfang oder das Versenden solcher Bilder, zeigt Warnungen an und warnt die Eltern, dass das Kind sie versendet oder angesehen hat.

Apple hat klargestellt, dass keine dieser Funktionen die Privatsphäre des Nutzers beim Umgang mit CSAM gefährdet. Für den iCloud-Erkennungsmechanismus wird eine ausgeklügelte Kryptographie verwendet, um zu verhindern, dass der Scan-Mechanismus auf Bilder zugreift, die keine CSAM sind. Apple ist sich sicher, dass das neue System eine wichtige Rolle bei der Ausbeutung von Kindern spielen könnte, da es alle räuberischen Nachrichten unterbrechen kann, und es wird von einer Reihe von Kryptographie-Experten befürwortet.

- Teil 1: Was ist die CSAM-Erkennung von Apple?

- Teil 2: Warum scheint Apples CSAM umstritten zu sein?

- Teil 3: Kann ich die CSAM-Erkennung stoppen?

- Teil 4: Was ist die jüngste Reaktion von Apple auf die CSAM-Kontroverse?

Teil 1: Was ist die CSAM-Erkennung von Apple?

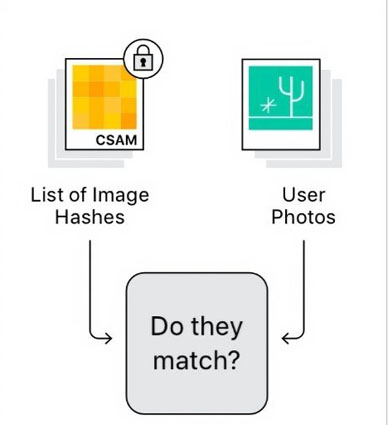

Im Grunde genommen hat Apple drei separate Updates angekündigt, und jedes dieser Updates steht im Zusammenhang mit der Kindersicherheit. CSAM ist das bedeutendste dieser Updates, da es viel Aufmerksamkeit erregt hat, und es ist eine besondere Funktion, die in der Lage ist, die iCloud-Fotos zu scannen. Diese Funktion kann die Bilder der Nutzer mit einer Datenbank des zuvor identifizierten Materials vergleichen. Ein Überprüfungsprozess wird ausgelöst, wenn eine bestimmte Anzahl von Bildern erkannt wird.

Apple wird das iCloud-Konto sperren, wenn die Bilder zufällig von den menschlichen Prüfern verifiziert werden, und dies wird automatisch an das NCMEC oder National Center for Missing and Exploited Children gemeldet. Es gibt auch Sicherheitsfunktionen für die Nachrichten-App, die die App in die Lage versetzen, zu erkennen, wenn Kinder Fotos senden oder empfangen, die sexuell eindeutig sind.

Kinder, die älter als 13 Jahre sind, werden beim Empfang eines expliziten Bildes in der Nachrichten-App eine Warnung erhalten. Darüber hinaus aktualisiert Apple auch seine Recherchefähigkeiten und Siri, um bei Fragen zu CSAM einzugreifen. Siri wird in der Lage sein, Links zu den Ressourcen bereitzustellen, wenn man wissen muss, wie man das Missbrauchsmaterial melden kann.

Teil 2: Warum scheint Apples CSAM umstritten zu sein?

Obwohl viele Menschen der Meinung sind, dass dieses spezielle System in seinem Umfang angemessen begrenzt ist, sind eine Reihe von Wächtern, Experten und Verfechtern des Datenschutzes grundsätzlich besorgt über das Missbrauchspotenzial des Systems. Eine Reihe von Cloud-Speicheranbietern wie Microsoft und Dropbox führen bereits eine Bilderkennung auf ihren Servern durch. Daher sind viele Menschen mit dem System nicht einverstanden und denken sogar darüber nach, auf Android-Telefone umzusteigen, wenn es so weitergeht. Außerdem gibt es verschiedene Kontroversen über das Apple CSAM, so dass verschiedene Leute gemischte Bewertungen abgegeben haben.

1. Menschen, die zustimmen

- Benny Pinkas ist Kryptograph an der israelischen Bar-Ilan-Universität und glaubt, dass das PSI-System von Apple ein hervorragendes Gleichgewicht zwischen Nutzen und Datenschutz bietet. Seiner Meinung nach kann es konstruktiv sein, um jegliche CSAM-Inhalte zu identifizieren und gleichzeitig die Privatsphäre des Nutzers zu wahren und ein Minimum an Fehlalarmen zu vermeiden.

- Julie Cordia ist die Geschäftsführerin der Kinderschutzorganisation Thorn und glaubt, dass dieser Schritt von Apple dazu beiträgt, die Menschen der Gerechtigkeit näher zu bringen, insbesondere für die Überlebenden, deren traumatische Erlebnisse online verbreitet wurden.

- Kryptographen und Informatiker wie David Forsyth, Dan Boneh und Mihir Bellare sind der Ansicht, dass dieses System die Wahrscheinlichkeit, dass verschiedene Personen als Besitzer oder Nutzer von CSAM gefunden werden, erheblich erhöhen kann. Daher werden die harmlosen Nutzer einen minimalen Verlust ihrer Privatsphäre erleiden.

2. Menschen, die nicht einverstanden sind

- Nadim Koeissi ist Kryptograph und Gründer einer Firma namens Symbolic Software. Für Koeissi ist die Vorstellung, dass Ihr persönliches Gerät Sie auf der Grundlage bestimmter Kriterien für anstößige Inhalte scannt und überwacht und diese dann den Behörden meldet, eine ziemlich schlüpfrige Angelegenheit.

- Kendra Albert, eine Dozentin der Harvard Cyberlaw Clinic, hat ihre Bedenken bezüglich der Benachrichtigungen geäußert. Sie glaubt, dass dies dazu führen könnte, dass queere oder transsexuelle Kinder betroffen sind, da ihre Eltern ermutigt werden, sie auszuspionieren.

- Ein Professor des Stanford Internet Observatory namens Alex Stamos stellt die Fähigkeit von Apple in Frage, mit der Gemeinschaft der Verschlüsselungsspezialisten zusammenzuarbeiten. Er ist der Meinung, dass Apple sich in die Debatte über die Ausgewogenheit eingemischt und die Menschen ohne Diskussion oder öffentliche Konsultation in die äußerste Ecke gedrängt hat.

3. Andere Streitigkeiten über Apples CSAM

An der Universität Princeton sind zwei Wissenschaftler tätig, die behaupten, dass sie Apples CSAM definitiv für anfällig halten, da sie zuvor ein solches System entwickelt haben. Ihnen zufolge funktionierte das System auf die gleiche Weise, aber sie hatten schnell ein eklatantes Problem entdeckt.

- Die Washington Post hat einen Leitartikel veröffentlicht, in dem einige Forscherbehaupten, dass sie zwei Jahre damit verbracht haben, ein CSAM ähnlich dem von Apple zu entwickeln. Die Geschichte hat eine dramatische Wendung genommen, nachdem Apple zugegeben hat, dass es CSAM in den letzten drei Jahren eingesetzt hat. Daher betrachten sie es als eine ernste Warnung für Millionen von Apple iPhone-Nutzern.

Teil 3: Kann ich die CSAM-Erkennung stoppen?

Es gibt viele iPhone- und iPad-Nutzer, die sich Sorgen über die Erkennungsfunktion machen, die mit dem nächsten großen Update von iOS und iPadOS eingeführt werden könnte. Es gibt immer noch eine Option, die verfügbar ist, um Apple davon abzuhalten, die persönlichen Fotos von Personen zu scannen. Es ist erwähnenswert, dass dieses CSAM-Tool nur die Bilder untersucht, die Sie auf iCloud hochladen. Um die Dinge klarzustellen, werden keine Fotos vom Erkennungssystem gescannt, die der Nutzer über Ende-zu-Ende-verschlüsselte Apps wie Whatsapp oder Telegram sendet. Dennoch könnte dies im Gegensatz zu den ersten Warnungen stehen, die besagen, dass es in der Lage sein könnte, die Ende-zu-Ende-Verschlüsselung zu infiltrieren und somit eine richtige Funktion zu sein.

Wenn Sie bereits Fotos mit iCloud synchronisiert haben und das Erkennungstool daran hindern möchten, die Fotos zu scannen, müssen Sie die folgenden Schritte ausführen:

- Sie können damit beginnen, indem Sie die App „Einstellungen“ öffnen und dann zum Abschnitt „Fotos“ gehen.

- Sie müssen die iCloud-Fotos umschalten, um die Synchronisierung dieser Fotos mit der Cloud zu deaktivieren.

Um die Medien aus der iCloud-Mediathek zu erhalten, müssen Sie nur auf „Fotos und Videos laden“ klicken.

Teil 4: Was ist die neueste Antwort von Apple auf die CSAM-Kontroverse?

Apple dementiert nachdrücklich, die Privatsphäre zu verletzen oder frühere Zusagen zu widerrufen. Das Unternehmen hat ein zweites detailliertes Dokument veröffentlicht, in dem es auf die meisten der Behauptungen eingeht. Apple betont nach wie vor, dass es die Nutzerfotos nur mit bekannten Sammlungen von Material zur Ausbeutung von Kindern vergleicht. Eine Meldung wird also nicht ausgelöst, wenn es sich um Fotos der eigenen Kinder handelt.

Apple hat auch klar gesagt, dass die Wahrscheinlichkeit eines falsch-positiven Ergebnisses eins zu einer Billion beträgt, wenn man bedenkt, dass eine bestimmte Anzahl von Bildern erkannt werden muss, damit eine Überprüfung ausgelöst wird. Obwohl Apple den externen Forschern nicht viel Einblick in die Funktionsweise gegeben hat, sagen sie im Grunde, dass wir uns auf ihr Wort verlassen müssen.

Darüber hinaus sagt Apple, dass die manuelle Überprüfung auf menschliche Prüfer angewiesen ist und dass sie in der Lage ist, zu erkennen, ob CSAM aufgrund einesbösartigen Angriffs auf einem Gerät war. Das Unternehmen wird sich weigern, mit den Regierungen und den Strafverfolgungsbehörden zusammenzuarbeiten, da viele Institutionen in der Vergangenheit Änderungen verlangt haben, die die Privatsphäre der Nutzer beeinträchtigen.

Schlussfolgerung

In den letzten Tagen hat Apple immer wieder Klarheit über die angekündigte CSAM-Erkennungsfunktion geschaffen. Es wurde klar gesagt, dass CSAM nur für die in iCloud gespeicherten Fotos und nicht für die Videos gilt, während das Unternehmen seine CSAM-Implementierung als datenschutzfreundlich und datenschutzschonend im Vergleich zu anderen Unternehmen verteidigt, die dies anbieten. Allerdings hat das Unternehmen auch eingeräumt, dass in Zukunft noch viel mehr getan werden kann und die Pläne im Laufe der Zeit erweitert und weiterentwickelt werden können. Weitere Erklärungen zu CSAM werden im Laufe der Zeit folgen, wir können also abwarten, um mehr Klarheit zu erhalten.

Wir legen Wert auf Ihre Meinung zu den neuesten Entwicklungen in Bezug auf CSAM, die Apple vorgenommen hat, und möchten Sie daher bitten, Ihre Kommentare zu den Kindersicherheits-Updates von Apple unten abzugeben.